Event Camera-Based Real-Time Gesture Recognition for Improved Robotic Guidanceロボットへの指示伝達改善のためのイベントカメラを用いたリアルタイムでの「身振り(gesture)」の認識Muhammad Aitsam, Sergio Davies, Alessandro Di Nuovo

本論文はこちら https://ieeexplore.ieee.org/abstract/document/10650870

ご紹介している論文の全文は、オープンアクセスで読めるものもあれば、有料や購読者限定のものもあります。所属機関や契約状況によって閲覧できる場合がありますので、詳細は各リンク先をご参照ください。

ダイジェスト

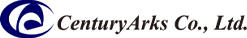

人間とロボットの協働作業における人間からロボットへの意思の伝達において、「身振り(gesture)」による意思の伝達は、自然で直感的な意思伝達手段を提供する。しかしながら、従来のフレームカメラではフレームレートが十分短くないために、「速い身振り」を捉えるにあたって「映像のぼやけ(motion blur)」を生じ、そのために正確な「身振り」の認識ができない場合がある。一方で、この問題を解決するためにフレームレートを短くすると、「身振り」の認識に不必要な大量の静的な背景の情報を取り込んでしまうといった問題が生じる。加えて、従来のフレームカメラは極端に明るい光環境あるいは極端に暗い光環境下では、目標とする映像を正確に取り込めないという問題もある。動的データのみを取り込むことによる不必要な静的データの削除、動的現象への素早い応答、マイクロ秒レベルの高い時間分解能、広いダイナミックレンジ、少ない消費電力といった優れた特徴を有するイベントカメラを使えば、従来のフレームカメラのこのような問題を解決することができる。

本研究では、まず、イベントカメラCenturyArks SilkyEvCam VGA event cameraによって得た動的な「身振り」のデータを収集して、それらのデータをロボットに組み込んだAIに学習させ、学習後のロボットが人間との協業において人間からの「身振り」による指示を誤りなく認識できるかを検証するための実験を行った。実験の結果、本研究で提案したモデルによって、ロボットによる人間の「身振り」の認識成功率として95.77%もの高い値を得ることができた。 本研究で提案・実証したシステムは、看護施設における高齢者と介助ロボットの意思疎通、口頭での伝達が難しい現場におけるロボットへの意思伝達などに活用できると考えられる。

Ph.D. Muhammad Aitsam, Sheffield Hallam University and Smart Interactive Technologies Research Lab

LinkedIn (https://www.linkedin.com/in/muhammad-aitsam-653894105/)

Google Scholar (https://scholar.google.co.uk/citations?user=8zEI5F8AAAAJ&hl)